- Affärsnyheter

- Alternativ hälsa

- Amerikansk fotboll

- Andlighet

- Animering och manga

- Astronomi

- Barn och familj

- Basket

- Berättelser för barn

- Böcker

- Buddhism

- Dagliga nyheter

- Dans och teater

- Design

- Djur

- Dokumentär

- Drama

- Efterprogram

- Entreprenörskap

- Fantasysporter

- Filmhistoria

- Filmintervjuer

- Filmrecensioner

- Filosofi

- Flyg

- Föräldraskap

- Fordon

- Fotboll

- Fritid

- Fysik

- Geovetenskap

- Golf

- Hälsa och motion

- Hantverk

- Hinduism

- Historia

- Hobbies

- Hockey

- Hus och trädgård

- Ideell

- Improvisering

- Investering

- Islam

- Judendom

- Karriär

- Kemi

- Komedi

- Komedifiktion

- Komediintervjuer

- Konst

- Kristendom

- Kurser

- Ledarskap

- Life Science

- Löpning

- Marknadsföring

- Mat

- Matematik

- Medicin

- Mental hälsa

- Mode och skönhet

- Motion

- Musik

- Musikhistoria

- Musikintervjuer

- Musikkommentarer

- Näringslära

- Näringsliv

- Natur

- Naturvetenskap

- Nyheter

- Nyhetskommentarer

- Personliga dagböcker

- Platser och resor

- Poddar

- Politik

- Relationer

- Religion

- Religion och spiritualitet

- Rugby

- Så gör man

- Sällskapsspel

- Samhälle och kultur

- Samhällsvetenskap

- Science fiction

- Sexualitet

- Simning

- Självhjälp

- Skönlitteratur

- Spel

- Sport

- Sportnyheter

- Språkkurs

- Stat och kommun

- Ståupp

- Tekniknyheter

- Teknologi

- Tennis

- TV och film

- TV-recensioner

- Underhållningsnyheter

- Utbildning

- Utbildning för barn

- Verkliga brott

- Vetenskap

- Vildmarken

- Visuell konst

Omtanke med Per Axbom

Per Axbom delar med sig av lärdomar om ny teknik och mänskliga rättigheter.

7 avsnitt • Längd: 0 min • Oregelbundet

Om podden

Per Axbom delar med sig av lärdomar om ny teknik och mänskliga rättigheter. För dig som strävar efter välbefinnande i ett modernt samhälle. Det är kåserier, essäer och spaningar som får dig att tänka… om.

The podcast Omtanke med Per Axbom is created by Per Axbom. The podcast and the artwork on this page are embedded on this page using the public podcast feed (RSS).

Avsnitt

Hotellets QR-koder banar väg för bedrägerier

När man varit tillbaka från semestern några veckor kan sommarens utflykter och samkväm kännas oerhört avlägsna. Men ett besvärande semesterminne från en känd svensk hotellkedja kan jag inte riktigt släppa. Inte för att rummet inte var till belåtenhet. Nej, det handlar om ett potpurri av papperslappar i promenoaren*. Eller en kavalkad av kuponger med QR-koder, om du så vill.

*En promenoar är en promenadkorridor eller foajé. Sådant som det finns gott om på just hotell.

Jag misstänker att det är ett arv från pandemin. Det här med att man nu förväntas boka vilken tid man ska äta frukost. Förbi är epoken när man kunde vakna på ett hotell, ligga och dra sig utan att bry sig om klockan, och så när det börjar kurra i magen saktmodigt krypa upp och ta sig med vana steg mot det logistiska haveri som fått namnet buffé.

Nuförtiden måste man alltså ställa in larm på telefonen så man inte missar det begränsade blocket för förtäring. En semesterskymf.

Men nej, det är inte heller detta som är det centrala för min förbittring. Jag vill rikta min högaffel mot systemet som förekommer själva bokningen av det tvingande tidsfönstret för fastebrytande.

Lapp-skoj

Utspridda på borden i lobbyn ligger de nämligen. Lapparna. Små lappar med ett piktogram av en mobil, och inom dess ritade ramar det som är ämnat att ge mig snabb respons, eller quick response. Inte många känner till det, men det är alltså just detta som bokstäverna QR står för i kodens namn: Quick. Response.

Denna betydelse är förstås en extra underhållande detalj när jag observerar förvirrade gäster ta god tid på sig att syna lappen. Med famlande poser och trevande mobiler försöker de aktivera de magiska krafterna i krumelurerna. Allt annat än raskt.

Det finns faktiskt ingenting på själva lappen som ger någon som helst indikation av vad syftet med QR-koden är. De ligger bara där i drivor.

När vi checkar in får vi till slut den muntliga vägledningen. Portiern pekar med påtaglig procedur på högen och förklarar: "Använd den här för att boka er frukosttid." Som om det vore det naturligaste i världen. Som om det alltid är ett förväntat beteende hos en semestergäst att planera in tiden för inställelse vid brödrosten ett dygn i förväg. Lediga, pyttsan.

Vilseledande manöver

Jag förstår nu att den snabba responsen är en mer träffande beskrivning av receptionistens förmåga att avfärda eventuella frågor med att peka på en lapp och skyndsamt vända sig till nästa intet ont anandes QR-offer i kön.

Jag tar en lapp ur högen. Och samma sekund vet jag hur oundvikligt det är att jag kommer skriva den här texten.

Nu hör det till saken att jag arbetar med säkerhet, tillgänglighet och trygghet på internet. Och den här smått solkiga pappersbiten råkar ge utrymme för det rakt motsatta: nämligen lömskhet, opålitlighet och bedrägeri.

Låt mig förklara.

En QR-kod kan leda dig vart som helst. Du kan inte själv läsa vad som är det förväntade målet när du aktiverar den. Och det är svårt att med blotta ögat direkt se skillnad på två olika QR-koder. Tänk nu att jag blandar in mina egna varianter av samma lapp i de där högarna på hotellet. Det enda jag byter ut är den där lilla fyrkantiga koden, men det ser förstås inte du.

Min QR-kod blandas in i högen

Det hotellet har gjort med denna praxis för frukostbokning är alltså att öppna upp för en miljö som är särskilt gynnsam för bondfångeri. Hotellpersonalen, en trovärdig och pålitlig aktör, pekar på en lapp och säger åt dig att skanna den med din privata mobil. Varför skulle jag inte lita på det?

"Men skulle jag inte märka att jag hamnar någon helt annanstans?" tänker du förstås. Det kan ibland stämma om du vet exakt vilken webbsida du är tänkt att hamna på. Men det har du nu inte informerats om när du stoppar lappen i fickan – med den falska QR-koden som jag blandat in – och beger dig mot rummet.

Jag som bedragare bygger förstås en webbsida med hotellets logotyp. Du känner direkt att du hamnat rätt med din QR-kod när du ligger på sängen och "ska bara fixa frukostbokningen" medan ditt sällskap i badrummet förbereder sig för aftonens galej. Sidan frågar efter namn och rumsnummer. Självklart för en frukostbokning, tycker du.

Kanske finns sedan en enkät som är frivillig men som ber om ännu lite personuppgifter, förmodligen din hemadress. Texten jag skrivit ljuger om att du kan vinna en hotellnatt. Hårtorken brölar nu i hallen så du passar på att ta chansen. Och vips så har jag mer av din privata data.

Som grädde på moset ber sedan min falska webbsida dig att välja tid för frukosten. Det är nämligen det praktiska med hotellets upplägg. Jag kan bakom kulisserna genomföra bokningen åt dig, precis som du förväntade dig. Det finns få skäl att misstänka att jag lurat av dig information. Uppgifter som du tänker att bara hotellet fått tillgång till.

En extra vinstchans

Om jag känner mig extra illmarig ber jag dig samtidigt att dela något i sociala medier för en extra vinstchans, och visar en inloggningsruta för att göra det. Nu har jag plötsligt också ditt användarnamn och lösenord. Som du i värsta fall använder på fler ställen.

Så för all del, käraste skandinaviska hotellkedja, fortsätt med det här upplägget om ni vill bidra till en utformning av digitalt stöd som passar som hand i handske för fingerfärdiga it-banditer. Det blir ett nyskapande gästgiveri där man just bjuder på, och ger av, sina gäster.

Men du som står i begrepp att skanna en QR-kod på en allmän plats, tänk efter före. Det är väldigt lätt för mig att med en enkel klisterlapp, försedd med min egen QR-kod, agera mellanhand och lura av dig dina personuppgifter. Eller mer.

Har QR-koden bytts ut?

Att förlita sig på QR-koder som vem som helst enkelt kan komma åt, och ersätta med sin egen, är som att bjuda brottslingarna på buffé. Särskilt då när de är utspridda på ett bord, eller sitter på en skylt, och inte överlämnas direkt av en rättrådig representant.

Det här kan förstås försätta mängder av människor i skadliga situationer. Boven gynnas av att avsändaren bjuder på trovärdigheten, vare sig det är ett hotell, ett byggbolag, turistbyrån eller kommunen.

Responsen från lagens lurade arm blir nog tyvärr allt annat än kvick. Om du ens märker vad som just hänt. Orka bry sig, liksom. Frukosten är bokad, din vän är festklädd och nu ska semestern firas in.

Låter det långsökt? Skanna QR-koden för att lämna en kommentar.

Lyssna

Exempel

Computer SwedenMartin Bayer

Computer SwedenMartin Bayer

AI-ansvar i en hajpad värld

Det är aldrig så lätt att bli lurad som under en pågående hajp. Det är mars 2023 och vi är mitt i den. Det är sällan jag sett så många anamma en helt ny experimentell lösning med så lite ifrågasättande. Just i detta nu är det oerhört viktigt att skaka av sig hypnosen och granska innehållet i den här nya flaskan med AI som flertalet börjat smutta på, eller redan börjat tanka sina företagsdatorer med. Ibland utan ledningens vetskap.

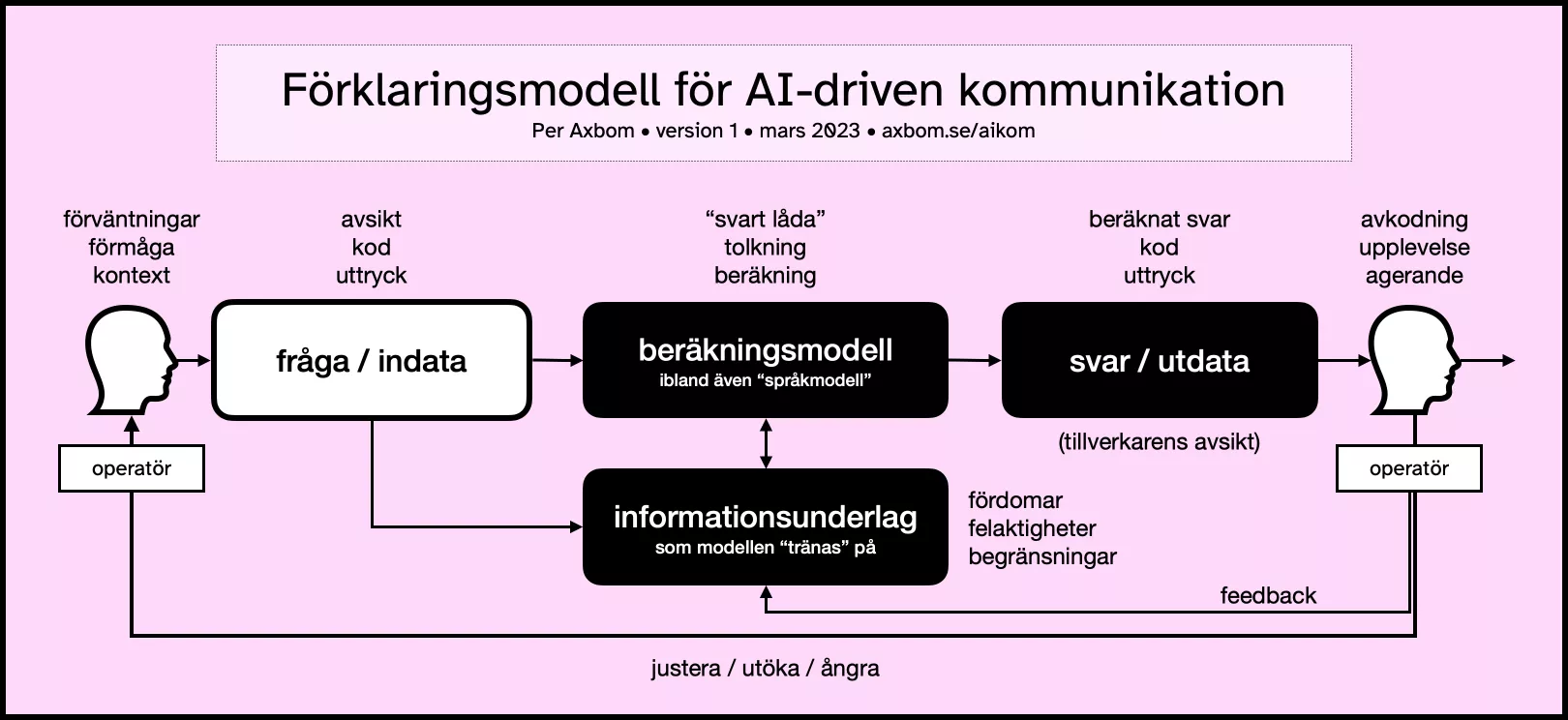

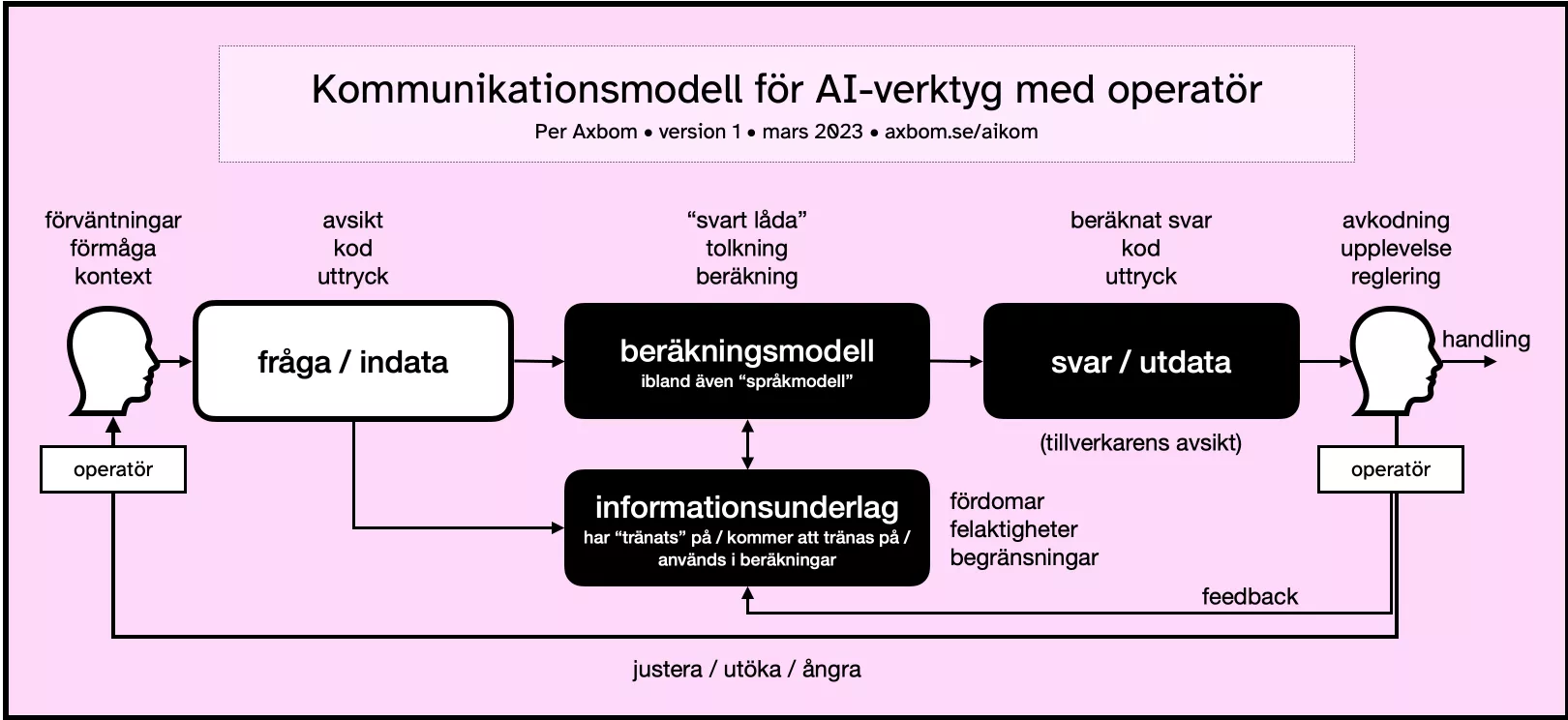

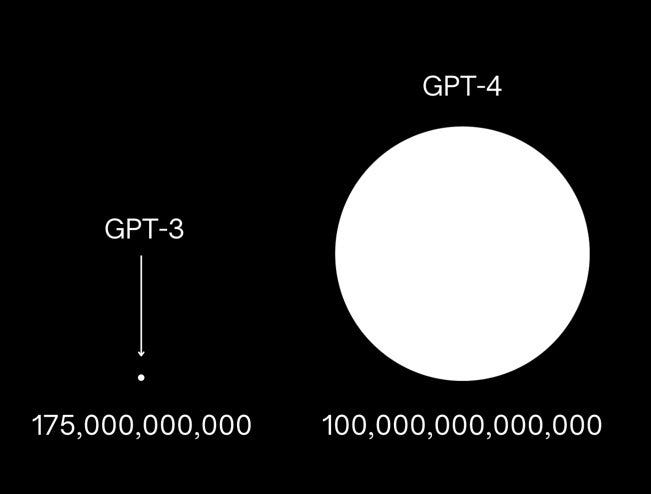

AI, ett begrepp som blev en akademisk inriktning 1956, har idag mest blivit ett marknadsföringsbegrepp för teknikföretag. Forskningsfältet grundar sig fortfarande i en teori om att mänsklig intelligens kan beskrivas så exakt att en maskin kan byggas som helt simulerar denna intelligens. Men ordet AI, när vi läser tidningen, beskriver oftast olika typer av matematiska beräkningsmodeller som, när de appliceras på stora mängder information, är tänkta att räkna ut och visa upp ett resultat som är underlag för olika former av förutsägelser, beslut och rekommendationer.

Tydligt svaga punkter i dessa beräkningsmodeller blir då till exempel:

- hur frågor ställs till beräkningsmodellen (man kan behöva ha väldigt specifika formuleringar för att få de resultat man vill ha),

- informationen den vilar sig mot för att göra sin uträkning (ofta fördomsfull eller otillräcklig),

- hur beräkningsmodellen faktiskt gör sin beräkning (det får vi alltför sällan veta eftersom företagen ser det som sin hemlighet, vilket åsyftas med black box – eller svart låda), och

- hur resultatet presenteras till operatören* (allt oftare som om maskinen är en tänkande varelse).

*Operatören är den som använder, eller kör, verktyget.

Det vi kallar AI i folkmun idag är alltså fortfarande väldigt långt ifrån något som tänker på egen hand. Även om texter som dessa verktyg genererar kan påminna oerhört mycket om texter skrivna av människor så är det inte konstigare än att den stora informationsmängd som beräkningsmodellen använder sig av är skriven av människor. Verktygen är byggda för att uppfattas kunna leverera svar som ser ut som människors svar, inte att faktiskt tänka som människor.

Eller ens leverera rätt svar.

Det är spännande och kittlande att prata om AI som självbestämmande. Men det är också farligt. Lägg därtill att en hel del av det som marknadsförs och säljs som AI idag helt enkelt inte är AI. Begreppet är oerhört tvetydigt och har en mängd olika definitioner som dessutom förändrats över tid. Det innebär mycket gynnsamma förhållanden för den som vill vilseleda.

Problem uppstår ofta när den akademiska inriktningens filosofiska grund sammanblandas med kommersiella aktörers vidlyftiga löften om teknikens förträfflighet. Och allmänheten, inklusive journalister, kan då självklart inte låta bli att associera tekniken till alla tiders berättelser om döda ting som får plötsligt liv.

Klipp från filmen Frankenstein (1931) där doktorn utropar att varelsen han skapat lever. "It's alive!" skriker han flera gånger.

Det är nästan som att det är precis den kopplingen företagen vill att människor ska göra.

Vi älskar självsäkra personligheter även när de har fel

Många tech-företag tycks vara så besatta av idén om en tänkande maskin att man gör allt för att få sina lösningar att framstå som tänkande och kännande när de egentligen inte är det.

Med Microsofts chat-bot för Bing har man till exempel valt att den i sina svar helt oförhappandes ska överösa sin operatör med emoji-symboler. Det är organisationens design-beslut för att göra maskinen mer mänsklig, självklart inte något som chat-botten själv ”hittat på”. Den är – hur tråkigt det än låter och hur mycket man än försöker göra den ”mänsklig” med personliga lyckönskningar – fortfarande ett dött ting utan förnimmelser. Även när det upplevs som att den skriver grova förolämpningar.

OpenAI:s ChatGPT uttrycker i sin tur de flesta av sina svar med en till synes obotlig självsäkerhet. Oavsett om svaren är rätt eller fel. I sina svar kan verktyget skapa referenser till verk som inte finns, tillskriva människor uppfattningar som de aldrig uttryckt eller upprepa kränkande åsikter. Om man råkar veta att den har fel och påpekar det så ber den om "ursäkt". Som om chatboten i sig kan vara ångerfull.

Sedan kan den i nästa sekund leverera ett helt nytt och lika felaktigt svar.

Ett problem med just de idoga, felaktiga svaren är förstås att det är svårt att veta att ChatGPT har fel om du inte själv redan vet svaret.

Såväl de komplett felaktiga svaren som boten:s förmåga att helt ändra sig när man påtalar fel är inte konstigt på något sätt. Det är så beräkningsmodellen fungerar. Du har säkert också hört detta kallas språkmodell, eller Large Language Model (LLM), men rent praktiskt är det fortfarande siffermässig behandling av observerade data som avgör vad verktyget skriver ut som svar.

Det som bör ifrågasättas är varför OpenAI väljer att låta boten presentera svaren på det här sättet. Det är helt enligt företagets utformning. Boten har inte själv "kommit på" att den ska vara självsäker utan att samtidigt upplysa om svagheter i sin egen beräkningsmodell. Det har OpenAI bestämt. Det är inte ChatGPT som är ångerfullt, det är företaget som vill att användaren ska skapa en emotionell koppling till ett dött ting.

Illusionen har till stor del lyckats. Designbesluten man tagit när man byggt dessa verktyg ifrågasätts i väldigt liten utsträckning. Fascinationen över svar som upplevs så oerhört mänskliga, och därför väldigt övertygande, får därför särskild uppmärksamhet.

– Titta här borta! som magikern skulle säga.

Självklart blir människor förförda. Det har tagits en rad designbeslut för att just förföra. Precis som det görs inom sociala medier eller e-handel. Verktygen byggs av människor som är oerhört kunniga inom psykologi, lingvistik och beteendeekonomi. Hur svaren presenteras rent formmässigt är långt ifrån en slump. Tillverkarna är lika måna om att påverka operatörens uppskattning av verktyget – trots tveksamma svar – som de förstås är om att försöka förbättra reglerna som styr beräkningsmodellen.

Mycket arbete och tid läggs på att presentera resultat så att de blir så engagerande och fängslande som möjligt. Det vi vet väldigt lite om är vad det långsiktigt gör med människors känsloliv och välbefinnande att regelbundet interagera med något som ger sken av att vara vid liv när det inte är det.

Det bristfälliga konsumentskyddet

Att vilseleda, designa och styra konsumenter mot specifika beteenden och känslor är förstås långt ifrån ett nytt fenomen. Det är dessutom ett fenomen som har gett upphov till lagar och organisationer som har till syfte att skydda konsumenter och hjälpa dem så att de inte hamnar i kläm.

USA:s motsvarighet till Konsumentverket, Federal Trade Commission (FTC), gick nyligen ut med en skrivelse som ber företag att hålla bättre koll på sina löften om vad AI kan och inte kan göra. Det är samtidigt en påminnelse till alla konsumenter om hur den pågående hajpen innebär risker.

Här är några av de beteenden som FTC identifierat och vill uppmärksamma:

- Företag överdriver vad AI-produkter kan göra. Ibland påstår de till och med att de kan göra saker som är långt över vad befintlig AI eller automatiserad teknik faktiskt kan åstadkomma idag. Det kan till exempel vara påståenden om att kunna förutse människors beteenden.

- Företag påstår att deras produkt med AI gör något bättre än en motsvarande produkt som inte har AI integrerat. Det här påståendet kan till exempel användas för att motivera ett högre pris. Ett sådant jämförande påstående behöver dock övertygande bevis, annars får man inte påstå det. Förmodligen bör man inte heller tro på det.

- Företag påstår att de säljer en AI-produkt men AI-teknik saknas. Ogrundade påståenden om AI-stöd i diverse digitala verktyg är inte helt ovanligt. FTC varnar specifikt för att användning av AI under utvecklingen av en produkt inte innebär att produkten innehåller AI.

- Företag känner inte till riskerna. Man måste känna till förutsägbara risker och produktens påverkan innan man släpper den på marknaden. Om något går fel, beslut tas på felaktiga grunder eller fördomar förstärks, så kan du inte skylla på en tredjepartsleverantör. Och du kan inte falla tillbaka på att tekniken är en "svart låda" som du inte förstår eller inte visste hur man testar.

Om du till exempel har funderat på att implementera en integration mot ChatGPT, har du då också funderat över det juridiska ansvar du får när något går fel?

Men "Det går snabbt nu!" och det finns en stor rädsla hos många för att missa tåget och inte vara med på ett av vår tids största teknikskiften. Snabba beslut går dock sällan hand i hand med genomtänkta beslut. Det kan därför vara mer värdefullt med en rädsla för att missa det ansvar man har om man ignorerar riskerna.

Men varför detta fokus på att röra sig så snabbt?

Nu förändras ALLT. Precis som vanligt.

Några som inte faller under granskning av Konsumentverket är den stora gruppen oberoende experter som nu blir inbjudna att uttala sig om företagen och deras nya AI-produkter i artiklar och tv-soffor.

"Det kommer gå snabbt nu", säger många experter, och påtalar att många företag kommer behöva rita om kartan helt för hur de bedriver sina verksamheter. Inte helt sällan är det samma experter som sa att vi kommer ha en stor andel självkörande bilar på våra vägar inom två år. För åtta år sedan.

Förklaringar på misslyckade spådomar efterfrågas inte men samma framtidsspanare får gärna om och om igen förtroendet att uttala sig om nästa stora teknikskifte med ogenerat övermod. Den självsäkerhet med vilken dessa spådomar uttrycks, och accepteras, kanske påminner dig om något? Kanske en chatbot nära dig.

Det är bekvämt och skönt med någon som kan uttala sig om allt det nya som händer och kan göra det på ett sätt som låter tvärsäkert, med formuleringar och ord som också inger förtroende. För vem skulle kunna alla de där orden om man inte är ordentligt påläst och trovärdig?

Vi vet ju innerst inne att framtiden inte alls går att förutse med säkerhet, men det är självklart roligare med någon som kommer med budskap om en häftig, spännande och ljusare framtid än någon som ber om lite lugn och eftertanke.

”Men det går inte att stoppa. Det är helt enkelt för kraftfullt!” säger många och tycks sälja idén om att vår uppgift i teknikbranschen är att sätta sig i närmaste kommersiella raket och hålla fast sig i något stadigt för nu blir det minsann åka av.

Man vill tydligen inte alls att vi tillsammans ska försöka bestämma vart vi vill att raketen ska ta vägen. Kanske bör vi i detta nu fundera över om de raketer som erbjuds - det vill säga specifika företags lösningar - verkligen är det bästa transportmedlet till just den framtid vi tänker oss som resmål.

Men det känns naivt av mig. Som om de människor som påverkas av innovationerna skulle få något att säga till om. Så dumt.

En ny tv-serie, Hello Tomorrow!, släpptes nyligen på Apples streaming-tjänst. I en retrofuturistisk framtid, tänk 'amerikanskt 50-tal med svävande bilar', ägnar sig en grupp säljare åt att resa runt i USA och kränga lägenheter de säger sig ha byggt på månen.

Serien påminner om hur vi människor gärna ser flykten till något annat som en lösning på våra problem här och nu. Och hur attraktionen till det nya kan grumla vår förmåga att på ett genomtänkt sätt bedöma dess giltighet, liksom dess förmåga att tillgodose våra egentliga behov. Se den gärna som en sedelärande berättelse om vikten av att stanna upp och ifrågasätta.

”Smart”, men fullständigt okunnig om mänsklig fara

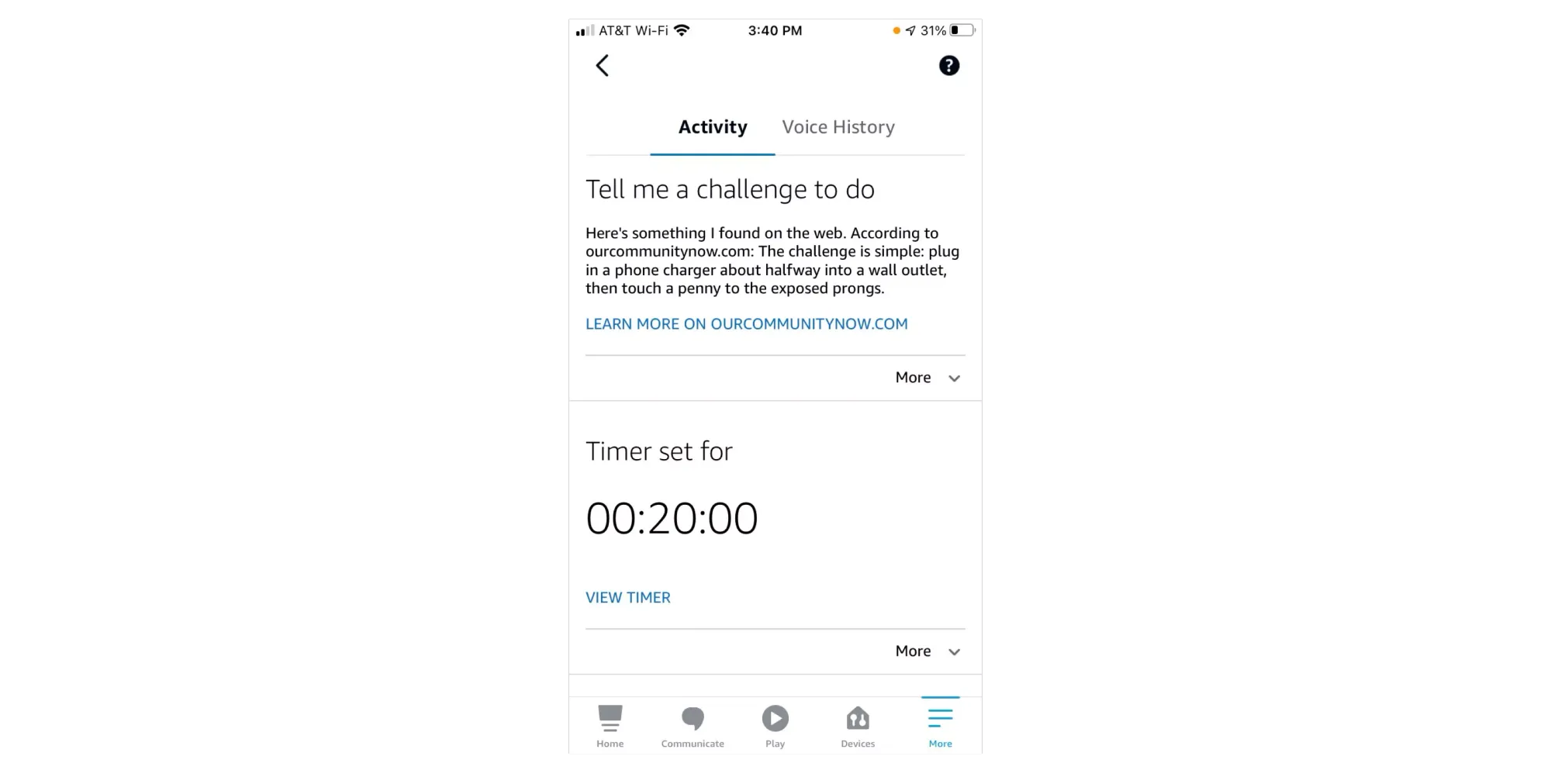

I december 2021, i ett kyligt Colorado, satt en 10-årig flicka inomhus med sin mamma och var uttråkad. De började använda Amazons chatbot Alexa och bad om utmaningar med saker att hitta på att göra. Jag vill ogärna kalla verktyget "smart" men onekligen är det ett chat-verktyg som marknadsförs som AI. Av denna bot fick mor och dotter tips på övningar för att motverka tristessen, som att ligga på golvet och rulla runt samtidigt som man håller en sko mot foten.

När flickan bad om nästa utmaning föreslog Alexa att flickan skulle göra The Penny Challenge. Det är en aktivitet som går ut på att stoppa en stickpropp endast halvvägs in i ett vägguttag och sedan hålla ett mynt mot ett av av de strömförande stiften. ”Nej Alexa! Nej!” skrek hennes mamma som hörde uppmaningen. I värsta fall kan ett sådant agerande leda till farliga stötar, utlösa brand och även leda till att man förlorar fingrar. Eller värre.

Som Alexa fungerade i detta fall så gör verktyget en Google-sökning men värderar inte de förslag som kommer som svar. Utmaningen ligger alltså ute på Internet – och när den hämtas därifrån och sedan presenteras av en chatbot från ett välkänt företag så vill man förstås gärna tro att den har gått igenom någon form av kvalitetsgranskning.

Men dessa chatbotar kvalitetsgranskar inte sina egna svar. Det som spottas ut är ett resultat av en beräkningsmodell som ibland kommer att förlita sig på livsfarlig information om den har tillgång till det.

När jag första första gången hörde att en journalist skrivit om hur Microsofts nya chatbot uppmuntrade honom till att lämna sin fru så lät det förstås absurt. Jag blev samtidigt irriterad över hur journalisten i fråga beskrev sina reaktioner och på många sätt ytterligare spädde på fantasifoster om att språkmodellen har ett medvetande. Och detta bara månader efter att det blev en världsnyhet att en ingenjör på Google fick för sig att en chatbot var vid liv. En ingenjör som sedan fick lämna sitt jobb.

Vid första läsning kan man tänka att hela härvan med en chatbot som uttryckte sin kärlek för journalisten bara växte fram som en knäpp effekt av hans udda frågor. Eftersom han självklart inte kommer lämna sin fru så känns det harmlöst.

Men ibland räcker det att tänka två steg till för att lägga grunden till en riskbedömning: kan samma chatbot till exempel skriva en text som ser ut som en uppmuntran till självskadebeteende? Kan den ge fyra tips om hur man bäst döljer självförvållade blåmärken?

Här har jag bara satt igång en tankebana men jag är övertygad om att du själv kan fylla i det jag inte säger. Det finns potentiellt tragiska konsekvenser av att språkmodeller tillåts på marknaden som kan uppmana och i det närmaste "hetsa" till beteenden som skadar den egna personen eller andra i dennes närhet. Utan att någon ber om det.

Vem bär i så fall ansvaret? Förvånansvärt många tycks argumentera att operatören själv är ansvarig. Att den som bygger verktyget och släpper det till allmänheten är utan skuld. Så resonerar gärna tillverkarna själva.

Men i samma ögonblick det finns en misstanke om att en maskin kan ge upphov till skada, så borde det innebära ett direkt skäl för politiker och konsumenträttsorganisationer att reagera och agera.

IKEA får återkalla gosedjur när plastögon utgör kvävningsrisk. Matvaror återkallas när de misstänks orsaka sjukdom. Bilar återkallas när man misstänker att några skruvar inte dragits åt på rätt sätt. Allt detta sker också ofta innan en enda människa har kommit till skada.

Men i fallet med flickan som fick förslaget att hålla ett mynt mot ett strömförande stift räckte det med att Amazon bara meddelade ”vi fixar det där” i ett uttalande. Så var det bra med det.

Och när psykisk ohälsa kan förstärkas av en maskin och leda till rysliga konsekvenser så viftas det lätt bort. Ingen behöver stå till svars för maskinens påverkan. Inget behöver regleras eller återkallas.

Vissa människor spelar mindre roll än andra.

I verktyget ChatGPT finns dessutom ett sorts inbyggt skydd mot ansvar. Två personer som ställer samma fråga får aldrig samma svar. I alla fall inte formulerat på exakt samma sätt. Hur kan vi verifiera skada om svaren inte går att replikera?

Jag slutar aldrig häpna över hur villiga vi är att ignorera potentiell skada för de mest utsatta när vi får tillgång till verktyg som gynnar oss själva. Ja, det gäller mig själv också. De positiva fördelarna jag själv åtnjuter stärker incitamenten för att ignorera negativ påverkan på andra. Människor vill ogärna förlora förmågor de en gång vunnit.

AI är inte neutralt. Det har aldrig varit det och kommer inte kunna bli det under en överskådlig framtid. Det är forskarna överens om. AI är en förlängning av det som redan finns. Fördomar inkluderat. Och förutom innehållet det är grundat på påverkas dess konsekvenser även av hur verktyget är utformat, och vem som får tillgång till det.

Allting går att sälja med mördande reklam

Klipp från visan Konserverad gröt (1948) med Ulf Peder Olrog. Här föds de bevingade orden "Allting går att sälja med mördande reklam."

Begreppet AI spelar tillverkarna i händerna. Det är tillräckligt fantasieggande för att frammana bilder från science fiction och förstärker känslan av att verkligen leva i framtiden. Men det är också tillräckligt luddigt för att tillverkaren ska undkomma ansvar om någon skulle kräva det.

"Det förstår du väl lille vän att du inte kan lita på en dator?"

Med vissa andra ord är företagen oerhört mer noggranna. Nyligen hade Google ett stormöte om sin nya AI-baserade Chatbot "Bard". En fråga från en anställd kändes oerhört uppfriskande:

"Bard och ChatGPT är 'stora språkmodeller' (LLM), inte kunskapsmodeller. De är jättebra för att generera text som låter som en människa, men de är inte bra på att säkerställa att den texten är faktabaserad. Varför tror vi att den första stora tillämpningen ska vara Sök, vars kärna är att hitta sanningsenlig information?"

Svaret från produktansvarige Jack Krawczyk är intressant. "Bard är inte sök." Han menar att det i stället gör sig bäst som en "kollaborativ AI-tjänst". Verktyget ska vara en "kreativ kompis" som hjälper dig att "sparka igång din fantasi och utforska din nyfikenhet". Han erkänner samtidigt att man inte kommer kunna stoppa människor från att använda det på samma sätt som "sök".

Delar av personalen säger sig ha lämnat mötet med fler frågor än svar, en omständighet som känns oerhört talande för samtiden.

Det är tydligt att tillverkarna inte riktigt vågar stå för svaren som verktygen just nu levererar. Så sakteliga inser de att det man lovar faktiskt måste matcha verkligheten lite bättre. För att inte råka ut för juridiska konsekvenser kan man inte säga att man får "svar" om en stor del av dessa är direkt felaktiga. Att i stället kalla de här nya, hajpade AI-tjänsterna för "kreativa kompisar" kanske flyttar ner förväntningarna några pinnhål. Men syftet blir desto mer diffust.

Samtidigt upplever företagen inga problem med att använda begreppet ”AI” och tycks inte heller känna sig nödgade att definiera vad det betyder.

Så här tänker jag: Företagen som tillverkar språkmodeller är usla på att tala om vad deras produkter faktiskt är till för eller förväntas utföra. De kan i bästa fall bidra med listor över exempel på saker som verktygen potentiellt eller eventuellt kan användas till. Med få ord om möjliga faror. Man kan dock läsa mellan raderna i villkorstexter, där företagen uttrycker att de till exempel försöker begränsa rasism, våld och porr.

Om du inte kan redovisa för hur det du byggt stämmer överens med det du hade för avsikt att bygga, hur bra är då egentligen resultatet? Svaret är: det kan du inte veta. Om du inte i förväg har indikerat vad intentionen med din produkt är kan du inte mäta om den lyckas med föresatsen.

Men det tillverkarna gillar mest är förstås att om de inte säger vad verktyget ska göra så kan de lättare komma runt ansvar för den negativa påverkan som verktyget bidrar till. Det är inte bara språkmodellen i sig självt, och hur dess beräkningar fungerar, som är dolda i en svart låda. Det är ofta också företagens intentioner.

I samma anda är användningen av ordet beta en genomtänkt metod. En gång en populariserad strategi à la Googles kostnadsfria e-posttjänst släpps idag många verktyg på marknaden med etiketten "beta-version". Det betyder att verktyget inte kan betraktas som färdigt och därför tycker man själv att man har mindre ansvar för hur bra det fungerar, eller för all del om någon far illa. Hur länge en produkt får använda epitetet beta eller hur många människor den får påverka under tiden tycks helt vara upp till företaget självt.

För dig som kanske inte minns så hade Gmail etiketten "beta" under hela fem år. Från 2004 till 2009.

Om ord får betyda vad som helst, hur skyddar man konsumenter?

Borde det egentligen alls få kallas AI, det som företagen håller på med? Det här begreppet som är så kittlande för såväl media som konsumenter, skapar det inte en helt felaktig bild av vad det är som pågår? Riskerar inte begreppet i sig att vilseleda och därmed vara det första och mest uppenbara bidraget till många missförstånd?

Företagen bäddar medvetet för uppfattningar som inte stämmer med verkligheten, och vet självklart att ett stort antal människor kommer tro att systemen de använder på något sätt är nära ett medvetande. Det skapar både orimliga förväntningar och rädslor.

Lek också för en stund med tanken att forskningsfältet någon gång i en avlägsen framtid faktiskt kommer på hur man kan replikera mänsklig intelligens, det som den akademiska inriktningen egentligen menar. Då är det faktiskt direkt pinsamt att det som byggs idag får kallas AI.

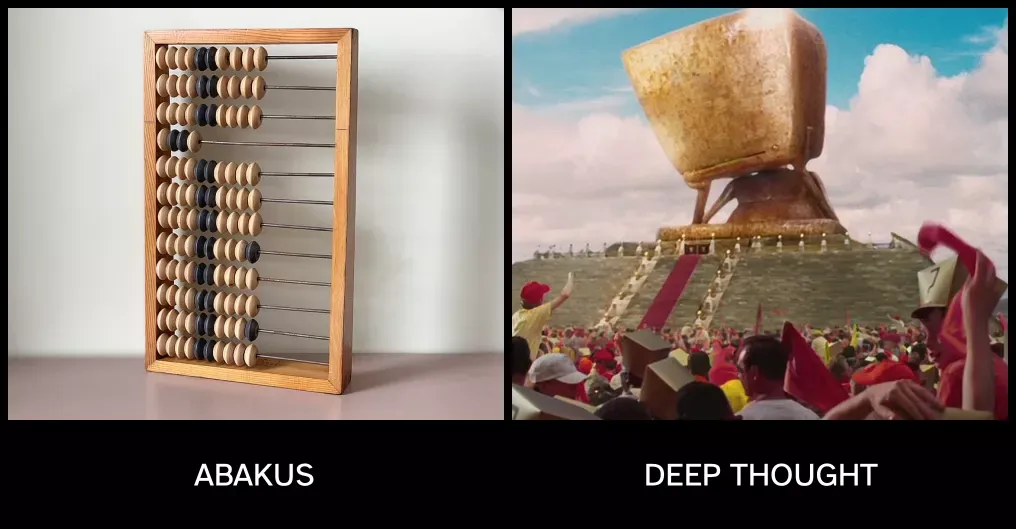

Det är som att en kulram skulle få marknadsföras som Deep Thought, du vet den där avancerade datorn i Liftarens guide till galaxen som räknar ut att lösningen på den ultimata frågan om livet, universum och allting är 42.

Nej, den datorn finns ju inte i verkligheten. Alltså precis som AI.

Jag är benägen att hålla med lingvisten Emily M. Bender om att det finns betydligt bättre begrepp än AI. Efter en AI-konferens år 2019 i Rom myntade en tidigare italiensk parlamentariker, Stefano Quintarelli, tillsammans med några vänner i stället begreppet Systematic Approaches to Learning Algorithms and Machine Inferences. På svenska ungefär: Systematiska angreppsätt för lärande algoritmer och maskinella inferenser, eller slutsatser. Det här begränsar omfattningen för vad vi pratar om på ett bättre sätt, och har dessutom en minnesvärd och lätt uttalad förkortning: SALAMI.

Vi kan då prata om produkter som är Powered by SALAMI och ställa oss existentiella frågor som:

- Kommer SALAMI utveckla ett känsloliv och en personlighet som påminner om en människas?

- Kan du bli kär i en SALAMI?

- Kommer SALAMI ta sig ur mänskliga begränsningar och utveckla ett jag som är vida överlägset människans?

Absolut, det kanske låter helknäppt. Men om man förstår vad det faktiskt är som får kallas AI idag så låter det också betydligt mer rimligt att tvinga fram ett byte till begrepp som inte vilseleder så många människor, med all den fara det kan innebära.

Hur förbereder jag mig själv och min organisation?

Vad händer när en organisations medarbetare matar in känslig information i ChatGPT och glömmer bort att de matar in informationen i någon annans dator? För något så trivialt kanske som att sammanfatta eller översätta eller kolla stavning kan personliga uppgifter överföras till någon annans ägo.

Ska man kanske utgå från att det redan hänt?

I ett aktuellt exempel från säkerhetsföretaget Cyberhaven så skrev en läkare in sin patients namn och diagnos i ChatGPT och bad chatboten skriva ett brev till patientens försäkringsbolag.

Vad blir din roll som ledare i en organisation i allt detta? Är det din roll att bara upprepa det tillverkarna själva säger, att bli hänförd och leka loss på alla möjliga tillämpningsområden? Jag vill påstå att din roll som ledare är att fördjupa dig på riktigt och vägleda din organisation. Att reda ut förmågor, styrkor och möjligheter men också risker och problem.

Hajpen just nu gör att många dåliga beslut kommer tas, många kommer bli lurade och många kommer göra investeringar som leder dem i fel riktning. Att springa ännu snabbare är ett jättebra sätt att förvärra situationen.

I bästa fall tas intiativ till att viktiga diskussioner förs innan verktygen börjar användas i omfattande utsträckning. I hälsosamma organisationer skapas förutsättningar för att medarbetare ska få – i trygga miljöer – prata om när, var och hur de ser fördelar och nackdelar.

Och dessa insikter måste förstås dokumenteras, bli vägledande, återbesökas och revideras regelbundet.

Men det finns kanske någon annan personlighet som du hellre vill lyssna på?

Min personlighet besvärar dig med att reflektera, förutse konsekvenser och mer medvetet välja riktning och användningsområden för modern teknik. Min personlighet vill att människor ska hållas ansvariga för det de tillverkar både innan och efter det bidrar till bekymmer.

Det finns förstås helt andra personligheter som lovar guld och gröna skogar och att allt kommer bli bättre nu om du bara sätter igång och börjar använda verktygen. Som vill att du inte ifrågasätter så mycket. Men gärna investerar. Helst igår. Personligheter som menar att det är en fantastisk tid vi lever i och nu tar vi nästa steg i att effektivisera arbeten och välfärd. Visst kanske någon råkar illa ut i periferin men inom två år kommer AI ha förändrat hela din verksamhet, säger experterna på tv.

Kanske finns det också en ledig lägenhet på månen.

“Om man inte vet var man ska är det ingen idé att skynda sig. Man vet ändå inte när man kommer fram.” – Nalle Puh

Självklart skapas det mängder av positiva effekter och hjälpsamma verktyg i detta tekniksprång. Men i ivern att 'effektivisera' är det alltför lätt att glömma hur det också skapas problem. Ofta för människor som har svårt att bli lyssnade på, eller är som mest sårbara. Det finns en hel del utrymme kvar för att både ta, och kräva, mer ansvar.

Om det är så att du vill tänka efter före och skapa förutsättningar för din organisation att göra det bästa av den här situationen, samtidigt som ni undviker att sticka iväg för snabbt i fel riktning, så kan jag hjälpa.

Du hittar mig via ChatXBM – garanterat fri från såväl AI som SALAMI.

Lyssna

Vidare läsning

inkl

inkl

IntelligencerElizabeth Weil

IntelligencerElizabeth Weil

Mediumaugmentedrobot

Mediumaugmentedrobot

The Radical AI Podcast0

The Radical AI Podcast0

axbom.sePer Axbom

axbom.sePer Axbom

The Road to AI We Can TrustGary Marcus

The Road to AI We Can TrustGary Marcus

axbom.comPer Axbom

axbom.comPer Axbom

The Road to AI We Can TrustGary Marcus

The Road to AI We Can TrustGary Marcus

Bonus

Apropå SALAMI: Jag skrev en helt annan typ av text om korvar redan 1995, och återpublicerade sedan den texten på bloggen. Den texten var ganska underhållande när det begav sig:

axbom.sePer Axbom

axbom.sePer Axbom

Adjö Dickinson, hallå AI-genererad litteratur

Samma hyllade AI-verktyg som sparar tid åt en grupp människor kommer stjäla mycket tid och skapa mycket huvudvärk för andra. Verktygen tvingar bland annat att vi ritar om kartan för hur litterära verk publiceras. Vi står inför en lavinartad ökning av böcker skrivna av maskiner, och redan nu har redaktörer tvingats pausa inlämningar av nya verk för att försöka hitta en hanterbar väg framåt.

I nuläget experimenterar många människor med att använda ChatGPT och liknande verktyg för att skriva allt ifrån romaner till scifi-noveller och barnböcker, komplett med illustrationer från andra generativa verktyg online. För den som hyser författardrömmar går det att att på mindre än ett dygn framställa en färdig e-bok och publicera den på Amazon.

Du kan bli en publicerad författare över en natt.

Det finns ett begrepp som beskriver känslan av att något inte riktigt står rätt till när utseendet hos en människa ska replikeras i humanoida objekt. Uncanny valley, på svenska ungefär ”kuslig sänka, eller dal”, är ett koncept som menar att det sker en dipp i förtroende – och känsla av olust – när det man ser framför sig saknar något man först inte riktigt kan sätta fingret på. Enligt hypotesen är dalen framför allt i gränslandet mellan ett utseende som är "nästan människa" och "helt och hållet människa".

Vi behöver nu ett liknande begrepp för den litteratur som kommer svämma över på marknaden, alster som bara efterliknar litterärt författarskap men inte riktigt når hela vägen. För erfarna redaktörer skapar dessa nämligen en tydlig känsla av obehag.

Clarkesworld är ett prestigefyllt månatligt magasin i USA som under nästan 20 års tid tagit emot och publicerat noveller inom science fiction och fantasy-genren. De har alltid svarat snabbt, ofta inom 48 timmar, och publicerade skribenter har fått ersättning för sina verk. Den 20 februari 2023 fick de stänga möjligheten att skicka in nya noveller efter att ha fått in rekordantalet 50 nya pitchar redan före lunch, de flesta helt uppenbart producerade av datorer.

Trots sin frustration har redaktören och utgivaren Neil Clarke en nykter syn på AI-genererad litteratur. Noveller kommer inte försvinna som fenomen, skriver han på sin blogg. Det är inte det som är problemet. Hans oro handlar främst om att nya skribenter och internationella författare kommer få det betydligt svårare att hitta en publik när större hinder måste upprättas för att mota bort de datorgenererade texterna. Kortfattad skönlitteratur behöver ett inflöde av nya röster, menar han, och det flödet kommer nu bromsas.

Genvägen till författarskap

För att bli en publicerad författare behöver man dock inte längre gå via ett magasin eller förlag. Man behöver inte ens betala pengar för att ge ut sin bok. Med Amazons tjänst Kindle Direct Publishing kan vem som helst skapa ett konto för att ge ut e-böcker och sälja dem via webbplatsen. Vill du erbjuda en pocketbok trycks den vid beställning on-demand.

Det här är något som Brett Schickler från New York insåg i januari. Med hjälp av ChatGPT skapade han en barnbok på 30 sidor om ekorren Sammy som lär sig spara pengar efter att ha hittat ett guldmynt. Sammy blir den mest förmögna ekorren i skogen. Även bilderna i boken The Wise Little Squirrel kommer från generativ AI.

I skrivande stund går boken inte längre att köpa till sin Kindle. Kanske har Amazon känt sig tvungna att granska publikationen givet den uppmärksamhet som Schickler fått, men det vet vi inte ännu.

En annan person som utnyttjat genvägen till författarskap är Frank White, som gett ut novellen Galactic Pimp, Vol 1 på strax över 100 sidor. I en 15 minuter lång video berättar han om hela processen och uppmuntrar andra att generera sina egna böcker.

Hans genomgång är onekligen lärorik. Efter att han beskrivit det fiktiva universum som boken ska utspela sig i så vill inte ChatGPT generera hela berättelsen åt honom på ett bräde. Men när han ber om exempel på kapitel efter kapitel där vissa saker ska hända, så skriver verktyget ut dessa åt honom. Han går också igenom vilka typer av ändringar han själv gjort. Han uppskattar att ChatGPT gav honom 17.000 ord och att han själv skrev 3.000 ord.

I ett inlägg på Reddit berättar ”författaren” om hur förvånad han själv också är över att vissa scener i boken gick längre än han trodde att AI-verktyget fick göra (min översättning):

Ja, ChatGPT har förmågan att skildra grafiskt våld och till och med skriva erotiska passager. Jag tycks ha lyckats rundgå några filter genom ren och skär repetition av dessa teman.

White ger oss också en spådom:

Inom fem år tror jag att 50% av böcker kommer vara skrivna på exakt det sätt som jag beskrivit hur jag skrev denna. Jag skrev den i princip på 24 timmar, och jag skapade ett jävligt bra bokomslag med hjälp av en $10-dollars prenumeration på en tjänst som kan generera en miljon av dessa om dagen om jag satt och gjorde det. Det här är framtiden och den här tekniken kommer till bio och filmproduktion. Romaner är bara den första etappen. […] Du kan nog skapa 300 romaner per år om du är seriös och jobbar med det varje dag.

Klipp från Frank Whites video:

Frank White delar med sig av tankar om framtiden för AI-genererad litteratur.

Hur många böcker skrivna med hjälp av AI-verktyg som det just nu finns på marknaden är omöjligt att avgöra, eftersom det inte finns krav på att den som publicerar en bok måste uppge det. Några hundra böcker listar dock ChatGPT som medförfattare. Och ja, självklart finns det böcker att köpa om hur du använder ChatGPT, skrivna av ChatGPT.

"Gör som du vill, vi svär oss fria från ansvar"

Frågan är nu hur omvärldens respons på detta kommer se ut. Om det sker en exponentiell ökning av antalet böcker, kommer nya filter behövas för att hjälpa oss sålla bland alla dessa? Kommer det behövas krav på att uppge ChatGPT som författare? Vilka verktyg kommer skapas för att avslöja datorgenererade böcker och vilka verktyg kommer skapas för att undgå denna detektion?

Vad vill vi? Vad vill du? Vilka fler problem kommer dyka upp?

Trenden vi sett de senaste åren är att digitala verktyg skapas som tar väldigt lite ansvar för de följdeffekter deras användning leder till. De har ofta inte ens ett uttalat syfte eller avsedd användning som beskriver vilket problem man försöker lösa eller vilket behov man vill tillgodose. En omständighet som förstås underlättar flykten från ansvarstagande.

Effekterna kan komma snabbt och vara omvälvande när det handlar om teknik som har exponentiell tillväxt som inneboende egenskap. Det lämnas gärna åt andra än verktygens tillverkare att ta hand om dessa effekter. I första led sparar tjänsterna kanske tid, men påverkan i andra och tredje led innebär ofta ökade kostnader i tid och pengar för någon helt annan. Inte sällan drabbas den som redan kämpar mest och har minst att sätta emot.

Och då har vi inte ens pratat om kodade fördomar, osanningar som uttrycks med ogenerad självsäkerhet, eller den energikonsumtion som maskininlärning kräver och uppmuntrar till.

Dagens problem kommer från gårdagens lösningar [1]. När vi uppfinner nya lösningar idag är det rimligt att fundera över, och redogöra för, vilka problem vi skapar åt morgondagen att ta hand om.

Nog borde någon form av ansvar kunna krävas av den som möjliggör och förstärker nya bekymmer. Säkert har någon skrivit en bok om det.

Formuleringen är känd från Peter Senges bok Den femte disciplinen. ↩︎

Lyssna

Läs mer

inkl

inkl

inkl

inkl

YouTube

YouTube

YouTube

YouTube

YouTube

YouTube

YouTube

YouTube

Förmågan som gör mig till den jag är

– Men vad är det du arbetar med egentligen Per?

Jag får frågan då och då i arbetslivet. Genom åren har den, i motsats till vad jag kanske förväntat mig, blivit svårare att svara på. Inte för att jag inte vet, utan för att det inte går att paketera i ett fint litet produktnamn.

Kunder vill köpa UX, eller tillgänglighet, eller något annat som har med digital design att göra. Eller kanske en workshop-facilitator eller kursledare. Någon som man kan passa in i en mall.

Min styrka, och svaghet, har alltid varit att jag inte passar in i mallen. Och inte vill. Jag kan vara allt det där man frågar efter. På papperet. Men jag måste få vara något mer också. Kanske var det därför jag för 13 år sedan startade eget företag.

Jag är en lyssnare.

Jag lyssnar på det du säger. Och oerhört mycket på det du inte säger. Kanske kan man prata om röstläge, ordval, kroppsspråk. Jag har dock svårt att förklara det på annat sätt än så här: när jag lyssnar kan jag höra det du redan vet men ännu inte hört dig själv säga.

Att vara en lyssnare har gett mig enorma fördelar. Jag skyndar inte i onödan. När andra har bråttom att leverera binder de snabbt upp sig i tankar och idéer som kan bli svåra att släppa, även när de krockar med verkligheten.

Jag väntar tills jag är trygg med att inte ge mig iväg i fel riktning. Provar små steg, och lyssnar. Om och om igen under två decennier av arbete med digitala lösningar har jag sett hur sköldpaddan når målet innan haren.

Det problem du säger att du har kanske inte alls är det du behöver angripa först. Den lösning du säger dig se kanske har flera vägval med väldigt olika utfall.

Som lyssnare kan jag leverera det som skapar mer välbefinnande hos organisationen, hos dig och hos intressenter som påverkas av din verksamhet. Det kanske inte alltid blir exakt som du tänkt dig, men det blir ofta något oerhört värdefullt.

Ibland när jag lyssnat ett tag och någon i ett möte märker hur tyst jag varit kan jag få frågan “Vad tycker du Per?”.

Då ställer jag mig upp, går fram till en whiteboard, och berättar om det jag hört. Det som sas men inte inte alltid högt. Är det en digital lösning kanske det är ett gränssnitt jag ritar. Om det är en strategi kanske det är en tidslinje. Om det handlar om vägval kanske det är ett flödesdiagram.

Blir du nyfiken på vad jag skulle säga? Kanske är det dags att anlita mig.

Du har min tillåtelse att sätta vilken etikett du vill på min roll.

Men du får en lyssnare.

Du kan läsa om mina tjänster eller mina paketlösningar. Men hur jag bäst hjälper dig kanske blir tydligare om du tar kontakt.

Häng med på resan

Digitala arbetsverktyg, smarta apparater, AI och virtuella världar hyllas för problemen de löser medan problemen de bidrar till tystas ner eller förminskas.

Jag heter Per Axbom och är en svensk kommunikationsvetare född i Liberia. Min internationella uppväxt, mitt datorintresse från tidigt 80-tal, tillsammans med en passion för ansvarsfull innovation har utmynnat i ett djupt intresse för mänskliga rättigheter i digitala sammanhang.

Jag vill öka den generella kunskapen om skadlig påverkan och uppmuntra balanserade och ärliga konversationer om möjliga, rimliga och önskvärda vägval.

Efter att ha bloggat i mer än 25 år om det mänskliga perspektivet inom digitalisering kompletterar jag mina kanaler med ännu en podcast. Du får munsbitar med insikter i avsnitt på cirka 7 minuter som funkar att lyssna på lite när som helst, och emellanåt lite längre utvikningar om aktuella fenomen.

Använd gärna avsnitten som underlag för att reflektera men också diskutera med personer i din närhet.

Framtiden är inte förutbestämd och inte något som vi bara kan lämna åt andra att bestämma över. Framtiden är något vi tillsammans bidrar till med våra beslut. Men då måste vi också bättre förstå konsekvenserna av det vi själva gör idag och just nu.

För att vägleda innehållet vill jag gärna höra från dig. Vad är du nyfiken på? Vad tycker du är svårt att greppa i den snabba utvecklingen? Vad tycker du att media snurrar till och skulle behöva en tydligare förklaring? Hur påverkas din uppmärksamhet, ditt självbestämmande och din hälsa?

Hör av dig till [email protected]

Det olustiga ljudet av spårning online

Jag kan inte få oljudet ur huvudet. Människor som tittar på videon uttrycker förundran och förfäran. Och det är därför nederländska utvecklaren Bert Huberts experiment är så kraftfullt. Det avslöjar egentligen inte något vi inte redan borde veta. Något vi ofta väljer att ignorera. Det briljanta är att det gör oss oförmögna att ignorera.

Bert själv förklarar att han haft idén i åratal. Det är en så'n där grej som lever sitt liv i bakhuvudet tills en dag när stjärnorna står rätt och du råkar ha den där tidsluckan samtidigt som din gamla idé letar sig fram till pannloben.

Berts idé verkar simpel:

Hur skulle det vara om din dator gav ifrån sig ett litet ljud varje gång den skickar data till Google?

Så han byggde just det. En liten mjukvara med namnet googerteller fick liv i hans Linux-dator och ger ifrån ett skrapigt pip när datorn märker av information som flödar från hans egen dator till en av Googles datorer.

Och så här ser hans första video ut. Eller låter. Det är när han besöker den nederländska regeringens sida med lediga jobb. Bert noterar att sidan inte frågar om samtycke för den här överföringen.

Märk i början när varje tecken i sökrutan skickar data till Google för att kunna visa sökförslagen.

Video av Bert Hubert

Trycket ökar med fler spårare

Efter att ha berättat om sitt verktyg i en tweet fick hans video snabbt mer än en miljon visningar. Sporrad av uppmärksamheten beslöt sig Bert för att utveckla verktyget till att inkludera inte bara spårare från Google men även Facebook och ett dussintal andra spårningstjänster.

När han besöker några populära nyhetssajter låter nu hans dator så här:

Även om jag själv personligen är oerhört medveten om att den här spårningen pågår på de flesta sajter vi besöker idag, så får videon och dess läten mig ändå att rysa. Om det är så att du har svårt att höra kan jag berätta att ljudet i den andra videon är nästan konstant, även när Bert bara bläddrar i sidan.

Det är inte bara dataöverföringen i sig som är dilemmat. Föreställ dig mängden datortrafik som krävs när detta händer för alla som är aktiva online. Och mängden lagringutrymme och processorkraft som behövs för att hantera allt som samlas in. Ja, du fattar.

Makten i transparens

När vi pratar om transparens pratar vi ofta om att tala om för människor vad som pågår. Men ofta är transparensen i uttalanden och rapporter svår att ta till sig och förstå. Det här experimentet visar vad som händer när människor börjar förstå på ett annat sätt. En förklaring med ljud i realtid ger transparens en helt ny innebörd.

Och jag tror att det här bara är ett första steg. Kolla in Berts inlägg där han skriver om några idéer för att ta verktyget vidare, inklusive en publik installation av en live-demo.

Jag personligen skulle förstås gärna se ett sådant här verktyg tillgängligt för fler plattformar. Och det finns mycket potential i att låta användare välja spårare och olika ljud för olika företag. Och förstås ge möjligheten för visuell feedback för de som inte kan höra, som bubblor som dyker upp och spricker för varje informationsöverföring.

För någon som mig själv blir det nästan ett spel, där jag vill se vilka spårare jag lyckas blockera i min Hosts-fil, och vilka som tar sig igenom.

Om någon med bättre förmåga än jag själv bygger är jag definitivt intresserad av att bidra med designidéer. Jag pratar mycket om medvetenhet, och det här är en typ av verktyg jag tror skulle uppmuntra många fler människor till att ha viktiga samtal, och agera.

Tack Bert.

Sättet du skriver på ett tangentbord kan avslöja din identitet

Så tidigt som 1860 förstod erfarna telegrafioperatörer att de kunde känna igen individer på deras unika knackande på telegraf-knapparna. För ett tränat öra så kunde det mjuka tipp-tappandet hos varje operatör vara lika bekant som den talade rösten hos en familjemedlem.

Under andra världskriget använde underrättelsetjänster en metod känd som "Fist of the Sender", eller sändarens näve, för att identifiera unika sätt att knacka in streck och punkter i morsealfabetet. Det användes för att skilja vän från fiende. Takten och stilen i kommunikationen hjälpte operatörerna att härleda vem som var i andra änden.

Ju mer du skriver, desto mer av dina unika egenskaper kan samlas in och identifieras

Även om människor skriver på tangentbord i ungefär samma hastighet så har alla också paus-moment, sekvenser och håll-tider för särskilda bokstäver som endast gäller just dem. Ju fler av dessa variabler vi har tillgång till, desto säkrare kan vi bli på en persons identitet.

Vanliga felstavningar, grammatiska fel, favoritord, skiljetecken, stora och små bokstäver, samt användning av emoji-symboler kan dessutom spela roll i informationsinsamlingen. Ju mer som är känt desto närmare kommer vi något som är likvärdigt ett biometriskt fingeravtryck.

Den beteendemässiga biometriska identifikationen vi får via tangentbordet, känt som knapptrycks-dynamik (engelska: keystroke dynamics), blir förstås bara bättre över tid. Man kan till exempel ta hänsyn till att ditt sätt att skriva varierar över en dag eller dagar och att det kan påverkas av andra faktorer – till exempel vem du skriver till och om du är upprörd.

Ditt sätt att skriva kan identifiera dig när du tror att du är anonymiserad

Som du säkert redan förstått kan den här tekniken användas för att avhemliga den som vill vara anonym på nätet. Oavsett vilka andra säkerhetsåtgärder du tagit, kan loggning av knapptryck vara tillräckligt för att identifiera dig.

Vill du hålla dig under radarn? Att tejpa fingrarna på olika sätt, använda handskar och att konsumera alkohol kan säkert lura en del mjukvara. Men glöm inte att också utveckla ditt språk.

Lägg märke till att loggning av knapptryck är olagligt i de flesta länder (det jämförs med avlyssning) och förhoppningsvis inte så utbrett som man kan befara. Men informationen är oerhört lätt att samla i den digitala världen, av valfri webbplats, och svårt att upptäcka om man inte letar efter det. Skaparna av mjukvaran är oftast inte utbildade i att förutse potentiellt missbruk eller så vet de inte ens om att det de gör är olagligt. Facebook började analysera det du skrev, även när du inte publicerar, redan för flera år sedan.

Vem som gör vad i dagens digitala värld är inte alltid uppenbart, och ibland sker loggning med argumentet att det förbättrar säkerheten - vilket ibland är berättigat och ibland inte. Men återigen: din kontroll som konsument och användare är i stort obefintlig. Medvetenhet är allt vi kan sprida.

Den 24 maj, 1844, skickade Samuel Morse ett historiskt telegrafi-meddelande från Washington, D.C. till Alfred Vail i Baltimore, Maryland. Meddelandet löd:

"What hath God wrought?". (ungefär: Vad har Gud bringat?)

Den här frågan inbjuder förmodligen till mer reflektion än den mer moderna varianten av att signalera livstecken från ny teknik och programvara: "Hello world."

Läs mer

På engelska:

Wikimedia Foundation, Inc.Contributors to Wikimedia projects

Wikimedia Foundation, Inc.Contributors to Wikimedia projects

Columbia EntrepreneurshipColumbia Entrepreneurship | July 22, 2015

Columbia EntrepreneurshipColumbia Entrepreneurship | July 22, 2015

NASA/ADSJenkins, Jeffrey

NASA/ADSJenkins, Jeffrey

TechTargetIvy Wigmore,

TechTargetIvy Wigmore,

En liten tjänst av I'm With Friends. Finns även på engelska.